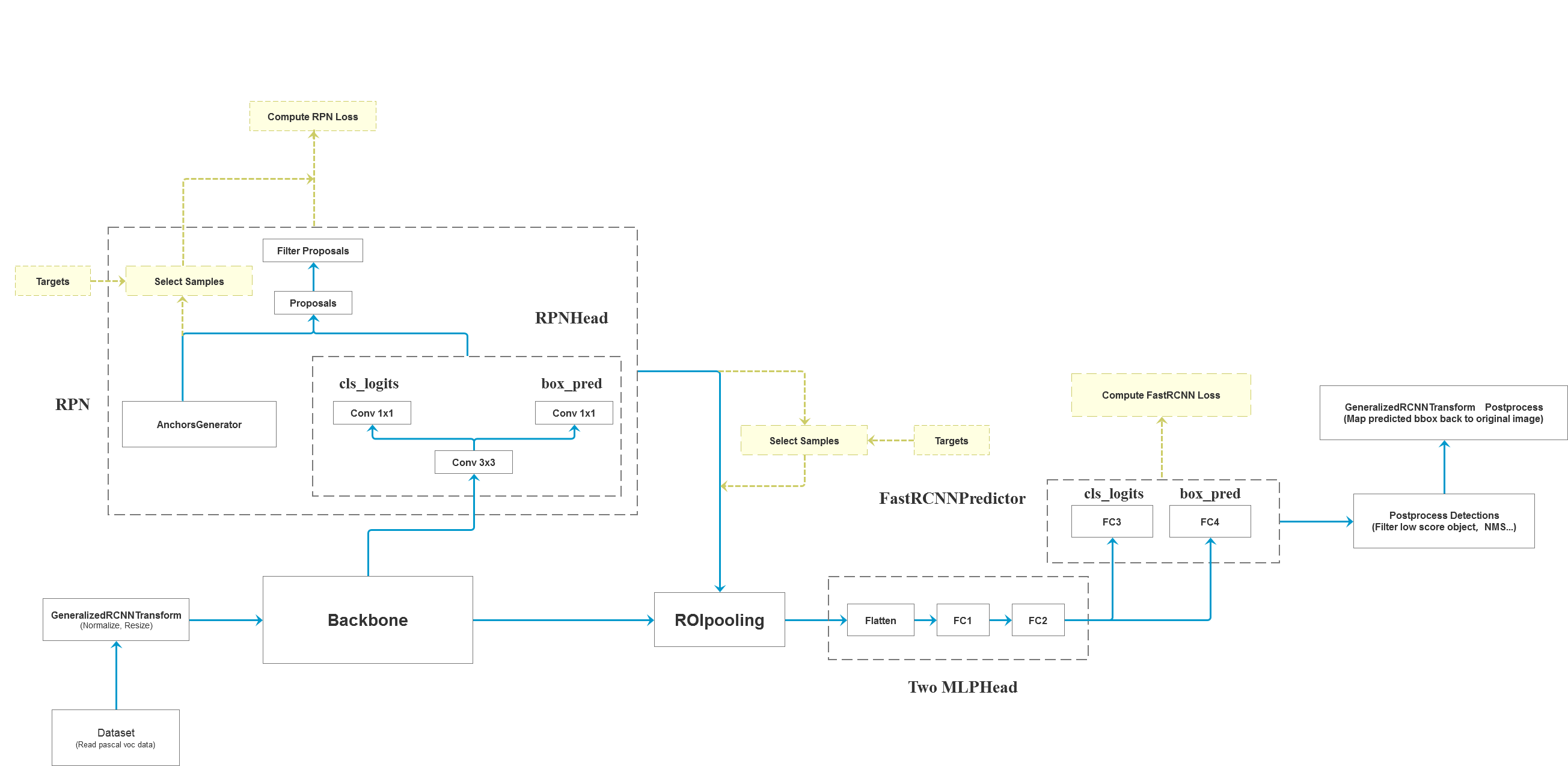

Faster RCNN框架图

源码主要内容

Faster R-CNN源码阅读将从以下几个方面展开,详见其他文档

-

DataSet

-

网络框架

-

GeneralizedRCNNTransform

-

RPN

-

Predict Header

-

正负样本划分与采样

-

Loss函数

-

PostProcess

-

Change Backbone(with FPN)

环境配置

- Python 3.6/3.7/3.8

- Pytorch>=1.6.0

- pycocotools

- Ubuntu or Centos

- Use Gpu to train model

- more details see requirements.txt

文件结构

├── backbone: 特征提取网络,可以根据自己的要求选择

├── network_files: Faster R-CNN网络(包括Fast R-CNN以及RPN等模块)

├── train_utils: 训练验证相关模块(包括cocotools)

├── my_dataset.py: 自定义dataset用于读取VOC数据集

├── train_mobilenet.py: 以MobileNetV2做为backbone进行训练

├── train_resnet50_fpn.py: 以resnet50+FPN做为backbone进行训练

├── train_multi_GPU.py: 针对使用多GPU的用户使用

├── predict.py: 简易的预测脚本,使用训练好的权重进行预测测试

├── validation.py: 利用训练好的权重验证/测试数据的COCO指标,并生成record_mAP.txt文件

├── coco.json: coco数据集标签文件

└── pascal_voc_classes.json: pascal_voc标签文件预训练权重

- MobileNetV2 weights(下载后重命名为

mobilenet_v2.pth,然后放到bakcbone文件夹下): https://download.pytorch.org/models/mobilenet_v2-b0353104.pth - Resnet50 weights(下载后重命名为

resnet50.pth,然后放到bakcbone文件夹下): https://download.pytorch.org/models/resnet50-0676ba61.pth - ResNet50+FPN weights: https://download.pytorch.org/models/fasterrcnn_resnet50_fpn_coco-258fb6c6.pth

注意在源码中修改对应模型的路径与名称

数据集(以PASCAL VOC2012为例)

- Pascal VOC2012 train/val数据集下载地址:http://host.robots.ox.ac.uk/pascal/VOC/voc2012/VOCtrainval_11-May-2012.tar

- 如果不了解数据集或者想使用自己的数据集进行训练,请参考:https://b23.tv/F1kSCK

- 使用ResNet50+FPN以及迁移学习在VOC2012数据集上得到的权重: 链接:https://pan.baidu.com/s/1ifilndFRtAV5RDZINSHj5w 提取码:dsz8

训练

- 确保提前准备好数据集

- 确保提前下载好对应预训练模型权重

- 若要训练mobilenetv2+fasterrcnn,直接使用train_mobilenet.py训练脚本

- 若要训练resnet50+fpn+fasterrcnn,直接使用train_resnet50_fpn.py训练脚本

- 若要使用多GPU训练,使用

python -m torch.distributed.launch --nproc_per_node=8 --use_env train_multi_GPU.py指令,nproc_per_node参数为使用GPU数量 - 如果想指定使用哪些GPU设备可在指令前加上

CUDA_VISIBLE_DEVICES=0,3(例如我只要使用设备中的第1块和第4块GPU设备) CUDA_VISIBLE_DEVICES=0,3 python -m torch.distributed.launch --nproc_per_node=2 --use_env train_multi_GPU.py

注意事项

- 在使用训练脚本时,注意要将

--data-path(VOC_root)设置为自己存放VOCdevkit文件夹所在的根目录 - 由于带有FPN结构的Faster RCNN很吃显存,如果GPU的显存不够(如果batch_size小于8的话)建议在create_model函数中使用默认的norm_layer, 即不传递norm_layer变量,默认去使用FrozenBatchNorm2d(即不会去更新参数的bn层),使用中发现效果也很好。

- 训练过程中保存的

results.txt是每个epoch在验证集上的COCO指标,前12个值是COCO指标,后面两个值是训练平均损失以及学习率 - 在使用预测脚本时,要将

train_weights设置为你自己生成的权重路径。 - 使用validation文件时,注意确保你的验证集或者测试集中必须包含每个类别的目标,并且使用时只需要修改

--num-classes、--data-path和--weights-path即可,其他代码尽量不要改动

评论